螞蟻用陸產AI晶片 成本省2成

圖/美聯社

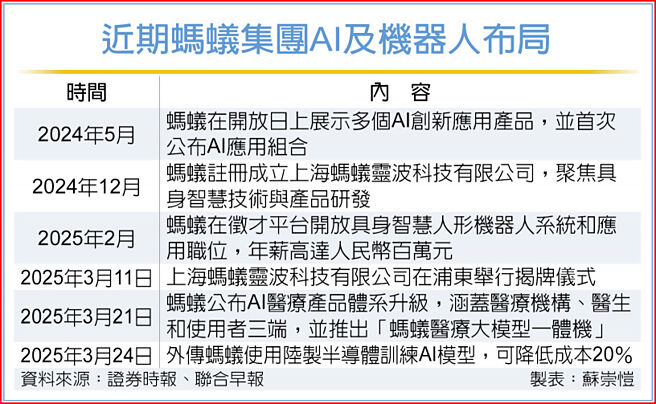

近期螞蟻集團AI及機器人佈局

自DeepSeek展示出如何以較低成本訓練AI模型以來,中美企業之間的AI競賽加劇。外媒24日報導,知情人士透露,大陸金融科技巨頭螞蟻集團使用陸制晶片來開發訓練AI模型的技術,可將成本降低20%。

聯合早報引述外電消息,知情人士指出,螞蟻集團使用包括阿里巴巴和華爲在內的陸制晶片,並透過混合專家(MoE)機器學習方式訓練模型。螞蟻集團指出,訓練結果與美國晶片巨頭輝達H800等晶片的結果相似。

證券時報報導,螞蟻集團Ling團隊近日發表一篇技術成果論文顯示,在五種不同的硬體配置上對9兆個token,進行Ling-Plus(百靈增強版,螞蟻的MoE大語言模型)的預訓練。其中使用高性能硬體配置訓練1兆token的預訓練成本,約人民幣(下同)635萬元,但利用螞蟻的優化方法後,使用低規格硬體的訓練成本將降至508萬元左右,節省近20%。最終達到與阿里通義Qwen2.5-72B-Instruct,以及DeepSeek-V2.5-1210-Chat相當的性能。

除了自研性能領先的大模型以外,該技術論文最大的突破在於,提出一系列創新方法,以提升資源受限環境下AI開發的效率與可及性。實驗表明,其3,000億參數的MoE大模型,可在使用陸制GPU的低性能設備上完成高效訓練,性能與完全使用輝達晶片、同規模的稠密模型及MoE模型相當。

報導指出,MoE模型的訓練通常依賴高性能運算資源(如輝達H100/H800等先進GPU),高昂成本制約在資源受限環境中的普及應用。同時,近年來輝達高性能晶片持續短缺,相比之下,低性能加速器供應更充足且單機成本更低。因此,Ling團隊設定的目標是「不使用高級GPU」來擴展模型,並透過提出創新性的訓練策略,突破資源與預算限制。

知情人士表示,螞蟻集團仍在使用輝達晶片進行AI開發,但現在其最新模型主要依賴,包括AMD和大陸晶片在內的替代品來訓練。